Оптимизация нейронных сетей: как это работает?

Оптимизация нейронных сетей — это процесс, который позволяет улучшить качество обучения модели, снижая ошибку и повышая точность предсказаний. Он жизненно важен для успешного применения алгоритмов машинного обучения, так как именно от него зависит, насколько быстро и эффективно нейронная сеть обучится на данных. Алгоритмы оптимизации играют ключевую роль в этом процессе, помогая направлять обновления весов сети в правильное русло.

Обзор основных алгоритмов оптимизации

Изучая область оптимизации, вы столкнётесь с несколькими основными алгоритмами, каждый из которых имеет свои особенности и преимущества. Стокастический градиентный спуск (SGD) был одним из первых оптимизаторов и остается популярным благодаря своей простоте. Затем появились методы, такие как Momentum, которые вводят понятие инерции в процесс обучения, позволяя сети быстрее двигаться в сторону минимума функции потерь.

AdaGrad стал первым алгоритмом, который существенно изменил подход к адаптации скорости обучения, позволяя ей варьироваться для каждого параметра. RMSProp продолжил эту тенденцию, улучшая AdaGrad и устраняя его недостаток чрезмерного уменьшения скорости обучения. Наконец, Adam, который сочетает все лучшие черты предыдущих методов, стал стандартом в современных задачах глубокого обучения.

Алгоритм Adam

История Adam началась в 2014 году, когда был представлен в статье, написанной Д. Кингмой и Дж. Ба. Алгоритм быстро завоевал популярность благодаря своей эффективности и простоте использования. Adam сочетает идеи из нескольких алгоритмов, предлагая адаптивное изменение скорости обучения, что делает его универсальным инструментом для решения широкого спектра задач.

Принципы работы Adam основаны на экспоненциально затухающих средних градиентов. Он использует два уровня средних: один для градиента, другой для квадратов градиента, что позволяет алгоритму поддерживать стабильную скорость обучения в течение всего процесса. Коррекция смещения, которая учитывается в первых итерациях, помогает сделать действия алгоритма более разумными и менее подверженными шумам в начальных этапах обучения.

Математическое описание Adam

Ключевым моментом в работе алгоритма Adam являются формулы обновления параметров, которые включают эквиваленты для первого и второго моментов градиентов. Эти формулы выглядят следующим образом:

- m_t = beta1 * m_{t-1} + (1 — beta1) * g_t — для первого момента (градиенты)

- v_t = beta2 * v_{t-1} + (1 — beta2) * g_t^2 — для второго момента (квадраты градиентов)

- theta_t = theta_{t-1} — (learning rate / (sqrt(v_t) + epsilon)) * m_t — обновление параметров

Параметры алгоритма, такие как скорость обучения (learning rate) и параметры beta1 и beta2, играют критическую роль в его работе. Сравнение с другими алгоритмами, например с RMSProp, показывает, что Adam, как правило, обеспечивает более быстрые результаты и лучшую устойчивость, особенно в случаях разреженных градиентов.

Преимущества использования Adam

Первое и главное преимущество Adam — это его адаптивная скорость обучения для каждого параметра. Это делает его идеальным выбором для моделей с большой размерностью. Быстрая сходимость и высокая стабильность являются вторыми значительными плюсами: модель чаще достигает оптимального состояния намного быстрее, чем при использовании других алгоритмов.

Кроме того, Adam демонстрирует высокую эффективность, особенно при работе с разреженными градиентами. Его использование в задачах, таких как обработка текста или изображений, показывает, что этот алгоритм может быстро находить решение, не теряя качества.

Ограничения и недостатки Adam

Несмотря на большое количество преимуществ, Adam имеет и свои недостатки. Он чувствителен к гиперпараметрам, что требует тщательной настройки для достижения наилучших результатов. Возможные проблемы с переобучением нередко возникают, если не соблюдаются правильные условия, особенно при работе с небольшими наборами данных.

Производительность Adam также может варьироваться в зависимости от специфических задач и архитектуры нейронной сети. Порой другие оптимизаторы показывают лучшие результаты в определенных условиях, особенно в случаях сложных и насыщенных моделей.

Вариации и улучшения Adam

Некоторые улучшенные версии Adam, такие как AdaMax и Nadam, предлагают дополнительные функции, базируясь на его принципах. AdaMax предлагает улучшение в работе со значениями, выходящими за пределы, а Nadam сочетает Adam с Nesterov Momentum, предлагая дополнительную инерцию.

Использование корректировок смещения для повышения стабильности алгоритма также становится популярным методом достижения лучших результатов. Это позволяет бороться с нежелательными эффектами и улучшает общее качество процесс обучения.

Практическое применение Adam в нейронных сетях

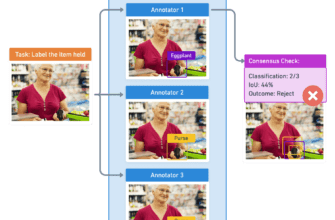

Среди архитектур, где алгоритм Adam проявляет свою эффективность, можно выделить CNN (сверточные нейронные сети), RNN (рекуррентные нейронные сети) и MLP (многослойные перцептроны). Сравнение результатов обучения, проведенное между Adam и другими оптимизаторами, часто демонстрирует быстрое сходимость и высокую стабильность при использовании первого.

Примеры успешного применения Adam в реальных задачах включают поиск изображений, классификацию текстов и переводы, где глубина сети и сложность данных делают Adam особенно полезным.

Инструменты и библиотеки для реализации Adam

Чтобы реализовать Adam, можно использовать популярные библиотеки, такие как TensorFlow и Keras. Эти инструменты предлагают готовые функции, что упрощает процесс настройки. Примеры кода можно найти в документации, что делает интеграцию алгоритма в проекты интуитивно понятной.

PyTorch также обеспечивает возможность использования Adam и предоставляет гибкость в настройке моделей. При работе с этими библиотеками научитесь обращать внимание на различные параметры и настраивать их в зависимости от ваших задач.

Процесс настройки гиперпараметров для Adam

Рекомендации по выбору начальной скорости обучения варьируются, но часто оптимальным значением является 0.001. Для достижения результатов, учитывайте тонкие настройки параметров beta1 и beta2, которые влияют на динамику обучения и быстрое сходимость.

Настройка гиперпараметров часто требует много времени и экспериментов, поэтому будьте терпеливы и опирайтесь на результаты. Для каждого конкретного проекта может потребоваться своя уникальная установка.

Примеры успешного применения алгоритмов оптимизации в реальных задачах

Кейсы из области компьютерного зрения показывают, что алгоритмы оптимизации, включая Adam, используются для создания моделей, способных распознавать лица, классифицировать объекты и даже улучшать качество изображений. В обработке естественного языка Adam нашёл применение в задачах перевода и обработки текстов, где его мощь оказывается незаменимой.

Будущие направления исследований в области алгоритмов оптимизации

Перспективы разработки новых методов и улучшения существующих алгоритмов оптимизации огромны. Интеграция оптимизации с другими подходами машинного обучения, такими как обучение с подкреплением, является одним из наиболее захватывающих направлений, где алгоритмы могут значительно улучшить свои результаты.

Заключение

Оптимизация нейронных сетей с помощью алгоритмов, таких как Adam, открывает перед нами новые горизонты в области машинного обучения. Зная преимущества и недостатки этих методов, можно эффективно применять их в своих проектах, повышая качество работы моделей. Не забывайте делиться своими мыслями и опытом в комментариях, а также не стесняйтесь делиться этой статьей в социальных сетях. Буду рад увидеть ваши отзывы и новые идеи, ведь ваши комментарии — это топливо для энтузиастов нейросетей!

Ссылки на источники: Yandex Education, Eitca, Habr.