Определение Reinforcement Learning (RL)

Reinforcement Learning (RL) – это область машинного обучения, где агенты обучаются принимать решения на основе взаимодействия с окружающей средой. Это делается через пробу и ошибку, где каждый выбор действий приводит к получению вознаграждения или наказания, что формирует поведение агента. Таким образом, RL ставит акцент на том, чтобы научить агента действовать в сложных условиях, оптимизировать свои действия и адаптироваться к изменениям.

Значение RL в контексте искусственного интеллекта

Разработка и применение RL технологий значительно усиливают возможности искусственного интеллекта, позволяя ему обучаться без необходимости в четком программировании. Эта способность самообучения делает RL неотъемлемой частью современных ИИ-систем, которые могут решать задачи, где заранее задать правила практически невозможно.

Отличия RL от других видов машинного обучения

В отличие от других методов машинного обучения, таких как обучение с учителем и без учителя, где модель обучается на заранее размеченных данных или выявляет структуры в необработанных данных, RL требует активного взаимодействия с окружающей средой. Это дает возможность делать выводы и адаптироваться практически в реальном времени, что крайне важно для динамических приложений.

Основные концепции RL

Агент и среда

Агент – это единица, которая принимает решения, взаимодействует со своей средой и учится на основе последствий своих действий. Среда определяет контекст, в котором агент действует и получает обратную связь.

Состояния и действия

Состояние – это описание текущего положения агента в среде. Действия – это выбор, который агент делает, чтобы изменить свое состояние. Каждый раз, когда агент действует, он меняет состояние, что и служит основой для его обучения.

Политика

Политика – это стратегия, которой следует агент для выбора действий в зависимости от текущего состояния. Это может быть детерминированная функция или стохастическая, когда одно и то же состояние может приводить к различным действиям.

Функция вознаграждения

Функция вознаграждения обеспечивает агента сигналом о том, насколько хорошо он справляется с задачей. Она определяет, какое вознаграждение агент получит за каждое действие, позволяя ему корректировать свое поведение.

Функция ценности

Функция ценности предсказывает, насколько ценно состояние или действие в долгосрочной перспективе, позволяя агенту делать выбор, основываясь не только на текущем вознаграждении, но и на потенциальных будущих выигрыше.

Процесс обучения в RL

Цикл взаимодействия агента со средой

Процесс обучения в RL основывается на цикле взаимодействия, где агент наблюдает состояние среды, выбирает действие, получает вознаграждение и обновляет свою политику на основе новой информации. Этот процесс продолжается до тех пор, пока агент не достигнет желаемого уровня эффективности.

Исследование и эксплуатация (Exploration vs Exploitation)

Ключевым аспектом является баланс между исследованием (поиск новых стратегий) и эксплуатацией (использование известных стратегий для получения вознаграждения). Эффективный агент должен не только пользоваться проверенными методами, но и искать новые возможности для улучшения.

Временные различия (Temporal Difference)

Алгоритмы обучения с временными различиями используют информацию о будущих состояниях и вознаграждениях для обновления оценок ценности. Этот метод позволяет увеличить стабильность и скорость обучения, основываясь на наблюдениях о прошлых действиях и их последствиях.

Ключевые алгоритмы RL

Q-learning

Q-learning – один из самых популярных алгоритмов RL, использующий значение Q для оценки качества действия в каждом состоянии. Агенты обновляют свою политику, основываясь на максимальном вознаграждении, заранее вычисляя наилучшие действия.

SARSA

SARSA (State-Action-Reward-State-Action) – это алгоритм, который обучает агента на основе последовательности состояния и действия, тем самым включающего в стратегию как текущее состояние, так и следующее действие.

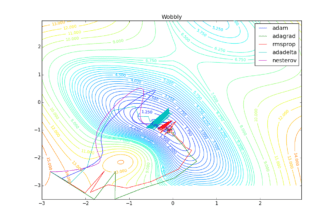

Методы градиента политики

Методы градиента политики оптимизируют надежность и производительность, изменяя параметры политики напрямую и уменьшая остаток между ожидаемым и полученным вознаграждением. Это позволяет более гибко адаптироваться к изменениям в среде.

Методы Монте-Карло

Методы Монте-Карло используют случайные образцы для оценки ценности действий, опираясь на среднем арифметическом результатов нескольких испытаний. Этот подход эффективен для задач, где действия агента имеют долгосрочные последствия.

Глубокое обучение с подкреплением (Deep RL)

Нейронные сети в контексте RL

Глубокое обучение интегрируется в RL, позволяя агентам обрабатывать сложные состояния с помощью нейронных сетей. Это существенно повышает возможности RL в сложных средах, где традиционные подходы не срабатывают.

DQN (Deep Q-Network)

DQN – это алгоритм, который комбинирует Q-learning с нейронными сетями, использующий их для приближения функции ценности. Это революционное решение позволяет агентам успешно справляться с высокоразмерными состояниями, применяя концепцию опыта повторного использования.

Политические градиенты (Policy Gradients)

Политические градиенты используют градиентный спуск для оптимизации параметров политики, основываясь на вознаграждении. Это позволяет агентам выставлять приоритеты для действия, которое они хотят изучать, способствуя улучшению стратегий.

Актор-критик (Actor-Critic) методы

Методы актора-критика смешивают преимущества методов градиента политики и ценности, используя два компонента: актор, который отвечает за выбор действий, и критик, который оценивает качество этих действий. Эта комбинация делает обучение более стабильным.

Марковские процессы принятия решений

Определение и свойства

Марковские процессы принятия решений (MDP) – это математическая модель, описывающая сложности выбора действий и состояний. Главная особенность – это свойство Маркова, которое говорит о том, что будущее состояние зависит только от текущего, а не от всех предыдущих состояний.

Связь с RL

RL можно трактовать как попытку решить задачи, поставленные MDP, где агент ищет оптимальную стратегию, основанную на взаимодействии с окружением. Эта связь позволяет использовать мощные математические инструменты для анализа и оптимизации процессов обучения.

Стратегии исследования

ε-жадная стратегия

ε-жадная стратегия предполагает, что агент будет в основном использовать известные действия, но периодически исследовать новые, выбирая случайные действия с вероятностью ε. Это создаёт баланс между исследованием возможностей и эксплуатацией знаний.

Softmax

Система Softmax использует вероятностное распределение для выбора действия, основываясь на значениях ценности. Это позволяет учитывать не только наилучшие действия, но и делать выбор среди других, менее оптимальных вариантов.

Верхняя граница доверия (UCB)

Метод UCB позволяет агентам оптимально балансировать между исследованием и эксплуатацией за счёт учёта неопределенности в оценке действий. Это помогает избегать инерции и постоянно открывать новые возможности для обучения.

Функции аппроксимации

Линейная аппроксимация

Линейная аппроксимация используется для упрощения сложных функций, позволяя быстро оценивать ценность состояния или действия. Этот метод подходит для простых задач, но в сложных случаях может быть недостаточным.

Нейронные сети как аппроксиматоры

Нейронные сети используются для аппроксимации функций ценности и политики, позволяя моделировать сложные взаимосвязи и обрабатывать большие объёмы данных. Это актуально для задач, где традиционные методы неэффективны.

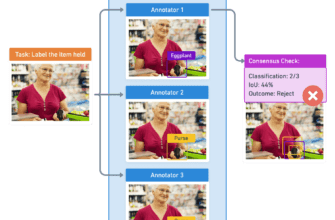

Многоагентные системы в RL

Кооперативное и конкурентное обучение

Многоагентные системы рассматривают ситуацию, когда несколько агентов взаимодействуют в одной среде, обеспечивая как кооперативное, так и конкурентное обучение. Это помогает развивать более сложные стратегии, где агенты могут помогать друг другу или конкурировать.

Проблемы координации

Одной из сложностей многоагентного обучения является необходимость координации действий агентов. Необходимость согласовывать стратегии, чтобы избежать конфликтов и максимально повысить своем эффективность, стоит на первом месте в многоагентных системах.

Применение RL в различных областях

Игры (шахматы, го, видеоигры)

RL успешно применяется в играх, где агенты могут достигать высочайшего уровня мастерства, играя против себя и совершенствуясь. Примеры включают алгоритмы, которые обыгрывают лучших игроков в шахматы и го.

Робототехника

В робототехнике RL помогает обучать роботов выполнять задачи, такие как манипуляция с объектами или навигация в сложных условиях. Это значительно улучшает возможности автономных систем в реальном мире.

Автономные транспортные средства

RL используется для разработки алгоритмов, управляющих автономными транспортными средствами, позволяя им принимать решения на дороге, основываясь на реальном взаимодействии с окружающей средой и другими транспортными средствами.

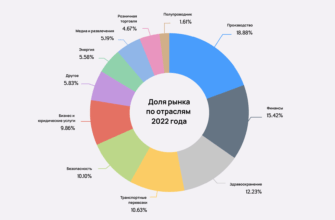

Финансы и трейдинг

Fiнансирование и трейдинг стали более эффективными благодаря RL, который позволяет моделировать динамику рынков и обучать агентов для оптимизации торговых стратегий, минимизируя риски.

Оптимизация ресурсов

Оптимизация ресурсов в производственных и логистических процессах также изрядно выиграла от внедрения технологий RL, позволяя эффективнее управлять запасами и снижать затраты.

Инструменты и фреймворки для RL

OpenAI Gym

OpenAI Gym – это популярная библиотека для разработки и тестирования алгоритмов RL, предлагающая большое разнообразие сред для обучения. Это отличный старт для тех, кто хочет погрузиться в РЛ.

TensorFlow-Agents

TensorFlow-Agents – это библиотека для построения RL-агентов, созданная на базе TensorFlow, позволяющая легко разрабатывать сложные модели и применять их на практике.

Stable Baselines

Stable Baselines – это набор улучшенных реализаций алгоритмов RL, который упрощает процесс обучения и тестирования, позволяя быстро внедрять готовые решения.

RLlib

RLlib – это фреймворк для масштабного обучения RL-агентов, который обеспечивает поддержку распределенного обучения и оптимизацию для больших задач.

Проблемы и ограничения RL

Проблема кредитного назначения

Проблема кредитного назначения заключается в том, чтобы понять, какие действия привели к какому вознаграждению, что усложняет обучение и делает его менее эффективным. Это сложность, с которой сталкиваются многие RL-алгоритмы.

Проблема масштабируемости

Масштабируемость – это ещё одна важная проблема, особенно когда речь идёт о сложных средах и задачах с высоким числом параметров. Разработка алгоритмов, которые могут эффективно работать в таких условиях, — это основное направление исследований.

Проблема переноса обучения

Перенос обучения – это сложность, когда агенты не могут эффективно применять знания, полученные в одной среде, в другой. Это ограничивает общие способности модели и требует разработки методов для более универсального обучения.

Передовые методы в RL

Мета-обучение

Мета-обучение направлено на создание алгоритмов, которые могут обучаться на новых задачах быстрее и эффективнее, используя опыт, полученный из предыдущих задач. Это позволяет предпринимать более продвинутые шаги в эволюции технологий.

Иерархическое RL

Иерархическое RL разлагает сложные задачи на более простые подзадачи, что позволяет гораздо быстрее достичь желаемого результата. Это подходит для многоуровневых или многозадачных ситуаций.

Обучение на основе любопытства

Обучение на основе любопытства подразумевает создание агентов, которые стремятся исследовать новую информацию за счет вознаграждения за открытие новых методов или данных. Это подходит для сред, где много неизвестного.

Этические аспекты RL

Безопасность и надежность RL-систем

Безопасность и надежность RL-систем остаются важными аспектами, требующими внимания, особенно когда они применяются в критически важных, высокорисковых областях, таких как медицина и транспорт. Необходимо внедрять строгие стандарты для гарантии надежности.

Проблемы предвзятости в RL

Проблемы предвзятости в исследованиях также возникают, когда алгоритмы могут наследовать или усугублять предвзятости данных, на которых они обучаются. Это создаёт необходимость в тщательном контроле за характеристиками данных на этапе обучения.

Практические советы по обучению агентов

Выбор подходящей среды

При выборе среды для обучения обращайте внимание на ее сложности и соответствие задачам, которые планируете решить. Это влияние среды на обучение и развитие агентов невозможно переоценить.

Настройка гиперпараметров

Настройка гиперпараметров – это ключ к успеху в обучении агентов. Пробуйте разные комбинации для достижения оптимальных результатов и не забывайте о тестировании на отдельных выборках данных.

Мониторинг и визуализация процесса обучения

Мониторьте и визуализируйте процесс обучения агентов для понимания их поведения и выявления возможных улучшений. Это не только упрощает анализ, но и помогает быстро реагировать на возникающие проблемы.

Будущие направления развития RL

Интеграция с другими областями ИИ

Интеграция RL с другими методами искусственного интеллекта, такими как обучение с учителем и без учителя, открывает новые горизонты, позволяя создавать более адаптивные и эффективные модели.

Применение в новых областях

Применение RL в новых областях, таких как экология, здравоохранение и персонализированная медицина, обещает революционизировать подходы к решению актуальных задач. Это расширяет горизонты и делает RL более универсальным инструментом.

Заключение

Reinforcement learning – это мощный инструмент, способный изменить подходы к обучению агентов и решению сложных задач. С развитием технологий и методов, применяйте RL для реализации своих замыслов и не забывайте учитывать этические аспекты. Будущее RL многообещающее, и именно вы можете стать его частью. Поделитесь своими мыслями и впечатлениями о статье в комментариях, и не забудьте обратиться к вашим друзьям и коллегам!

Источники:

- AWS: Что такое Reinforcement Learning?

- SkyPro: Обучение с подкреплением — основы и примеры

- Habr: Reinforcement Learning: Вводный курс

- Habr: Введение в Reinforcement Learning

- Yandex: Обучение с подкреплением

- Wikipedia: Обучение с подкреплением

- LiveJournal: Обучение с подкреплением — теория и практика

- FasterCapital: Большие данные и обучение с подкреплением