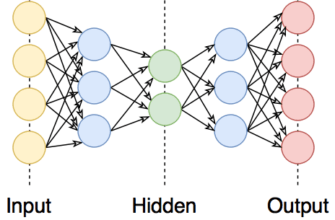

Наверное, каждый хоть раз задумывался, как компьютер может учиться, обрабатывать информацию и принимать решения. Шьется вопрос с необычным названием — градиентный спуск. Этот алгоритм стал одной из основ машинного обучения и важной частью обучения нейронных сетей. Если вы интересуетесь нейросетями и автоматизацией, то kesinно захотите глубже разобраться в этом упражнении. Готовы? Погружаемся в мир градиентного спуска, а заодно поднимем уровень понимания нейросетевой революции!

Основные понятия

Перед тем как покрыться пылью и приступить к практическим шагам, давайте разберем несколько незамысловатых понятий.

- Градиентный спуск — это итеративный метод оптимизации, который помогает минимизировать функцию потерь, чтобы улучшить результаты нейронной сети.

- Оптимизация — это процесс нахождения наилучших параметров модели, что сводит к минимуму ошибку предсказания.

- Обучение нейронных сетей — это процесс настройки весов и смещений нейронов для эффективного решения поставленных задач.

- Машинное обучение — это область ИИ, где алгоритмы обучаются на данных с целью автоматического улучшения производительности.

Каждый из этих терминов играет свою важную роль в общей картине, и понимание их взаимосвязи — первый шаг к мастерству в нейросетях.

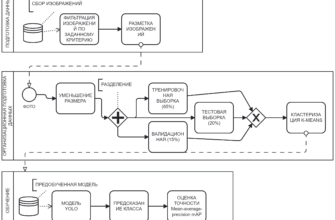

Пошаговая инструкция

Теперь, когда вы ознакомились с ключевыми понятиями, давайте рассмотрим, как работает градиентный спуск по шагам.

Шаг 1: Определите функцию потерь

Перед тем как начать обучение своей нейросети, выберите функцию потерь. Она измеряет, насколько ваши предсказания далеки от реальных значений. Наиболее распространённые функции потерь: среднеквадратичная ошибка (MSE) и бинарная кросс-энтропия.

Шаг 2: Инициализируйте параметры

Теперь вам нужно инициировать параметры нейронной сети, такие как веса и смещения. Используйте случайные значения или, что ещё лучше, методы инициализации, как Хавинштайн или Глорот. Параметры должны быть заданы плавно, чтобы избежать застоя в локальных минимумах.

Шаг 3: Вычислите градиент

В следующий раз вычисляйте градиент функции потерь относительно параметров. Используйте методы обратного распространения ошибки (backpropagation). Градиент показывает, в каком направлении и насколько сильно необходимо изменить параметры, чтобы уменьшить функцию потерь.

Шаг 4: Шаг потока

Теперь вам нужно сделать шаг в направлении градиента. Стандартный шаг называется агентом обучения (learning rate). Если он слишком мал, обучение занимает много времени. Если слишком велик — можно «перепрыгнуть» через оптимальные значения.

Шаг 5: Повторяйте!

Теперь, когда вы скорректировали параметры, возвращайтесь к расчёту градиента и повторяйте процесс, пока не достигнете желаемых результатов или не закончится заранее установленное количество итераций.

Практические советы

Теперь, когда вы знаете основные этапы градиентного спуска, вот несколько практических рекомендаций, которые помогут вам улучшить эффективность обучения нейронных сетей:

- Используйте мини-батчи: Вместо того, чтобы использовать весь набор данных, применяйте мини-батчи. Это улучшает стабильность и ускоряет обучение.

- Подбирайте скорость обучения: Применяйте методы вроде Adam, RMSprop или подобные адаптивные алгоритмы, которые самостоятельно подбирают скорость обучения.

- Регуляризация: Используйте L1, L2 или дроп-аут, чтобы избежать переобучения модели.

- Сохраняйте и проверяйте: Регулярно сохраняйте модель и тестируйте её на валидационных данных, чтобы избежать переобучения.

Заключение

Градиентный спуск — это не просто алгоритм, а настоящая сокровищница для исследователей и разработчиков нейросетей. Это та основа, на которой строится большинство современных машинных обучающих моделей. Понимание принципов его работы и правильное применение даст вам возможность создать высококачественные решения в области нейронных сетей. Так что не останавливайтесь на достигнутом, исследуйте дальше!

Теперь настало время вам попасть в этот захватывающий мир и попробовать самостоятельно реализовать градиентный спуск в своем проекте. Начинайте экспериментировать, делитесь своими выводами и оставайтесь любознательными. Успехов вам в вашем пути к мастерству в нейросетях!

И не забывайте, обучаясь и осваивая новые технологии, вы меняете мир к лучшему!

Если хотите узнать больше, ознакомьтесь с нашим другими статьями на тему машинного обучения и нейросетей.