Определение обучения без учителя

В мире машинного обучения существует множество методов и подходов, но обучение без учителя, пожалуй, один из самых загадочных. Обучение без учителя — это метод, который позволяет алгоритмам находить скрытые закономерности и структуры в данных, не имея при этом заранее определенных меток или ответов. Это похоже на изучение нового языка без учителя — просто погружаясь в среду и накапливая знания по ходу дела.

Отличие от обучения с учителем

В отличие от обучения с учителем, где данные имеют четкие метки, и алгоритм «знает», к чему стремиться, обучение без учителя предлагает более открытый и исследовательский подход. Здесь данные не имеют меток, и задача алгоритма — самостоятельно найти смысл в хаосе. Если обучение с учителем можно сравнить с уроком в школе, то обучение без учителя — это скорее свободное плавание в океане информации.

Значение в машинном обучении и анализе данных

Обучение без учителя имеет огромное значение в анализе данных и машинном обучении. Оно позволяет раскрывать скрытые паттерны в данных, которые могут быть неочевидны при обычном анализе. Это открывает новые горизонты в понимании и интерпретации сложных наборов данных, что особенно важно в эпоху больших данных.

Основные принципы обучения без учителя

Спонтанное обучение без вмешательства экспериментатора

Одним из ключевых аспектов обучения без учителя является его автономность. Алгоритмы работают самостоятельно, не нуждаясь в постоянном контроле со стороны человека. Это позволяет им обнаруживать новые и неожиданные закономерности, которые могли бы остаться незамеченными при ручном анализе.

Работа с неразмеченными данными

Важной особенностью обучения без учителя является работа с неразмеченными данными. Это позволяет использовать огромные объемы информации, которые были бы бесполезны в других методах машинного обучения. Алгоритмы сами находят смысл в данных, выявляя структуру и закономерности.

Поиск скрытых закономерностей и структур в данных

Основная задача алгоритмов обучения без учителя — поиск скрытых закономерностей и структур. Они помогают выявлять связи между данными, которые могут быть неочевидны на первый взгляд. Это делает их незаменимыми в сложных и многомерных задачах анализа данных.

Типы задач, решаемых с помощью обучения без учителя

- Кластеризация: Разделение данных на группы на основе схожести.

- Снижение размерности: Упрощение данных при сохранении их информативности.

- Обнаружение аномалий: Поиск необычных или редких событий в данных.

- Поиск ассоциативных правил: Выявление связей между переменными в данных.

- Визуализация данных: Преобразование сложных данных в наглядные графические формы.

Алгоритмы кластеризации

K-means

K-means — это один из самых простых и популярных алгоритмов кластеризации. Он делит данные на k кластеров, минимизируя расстояние между данными и центрами кластеров. Подробнее о K-means.

Иерархическая кластеризация

Этот алгоритм строит иерархию кластеров, создавая дерево, где каждое соединение представляет собой объединение двух кластеров. Это позволяет изучать данные на разных уровнях детализации.

DBSCAN

DBSCAN (Density-Based Spatial Clustering of Applications with Noise) основывается на плотности данных. Он может обнаруживать кластеры произвольной формы и работать с шумными данными. Узнать больше о DBSCAN.

Графовые алгоритмы кластеризации

Графовые алгоритмы используют графовые структуры для определения кластеров, основываясь на связях между точками данных. Они особенно полезны в сетевых данных и социальных графах.

Статистические алгоритмы кластеризации

Эти алгоритмы используют статистические методы для определения кластеров. Они могут учитывать распределение данных и их вероятность, что делает их полезными в сложных задачах анализа.

Алгоритмы снижения размерности

Метод главных компонент (PCA)

PCA — это метод, который позволяет уменьшить размерность данных, сохраняя как можно больше информации. Он выделяет основные компоненты данных и помогает избавиться от избыточной информации.

t-SNE

t-SNE (t-distributed Stochastic Neighbor Embedding) — это метод, используемый для визуализации данных в низкоразмерном пространстве. Он хорошо справляется с задачами визуализации многомерных данных, выявляя их структуры.

UMAP

UMAP (Uniform Manifold Approximation and Projection) — это алгоритм, который позволяет создавать низкоразмерные представления данных, сохраняя их топологические свойства. Он эффективен для визуализации больших наборов данных.

Алгоритмы обнаружения аномалий

Isolation Forest

Isolation Forest — это алгоритм, который использует случайные деревья для выявления аномалий в данных. Он изолирует аномальные точки, используя небольшое количество разбиений, что делает его эффективным и быстрым.

One-Class SVM

One-Class SVM — это метод, основанный на поддерживающих векторах, который создает модель для определения нормальных данных и выявления аномалий. Он полезен в задачах, где аномалии редки и сложно определить их явные характеристики.

Local Outlier Factor (LOF)

LOF определяет аномалии на основе локальной плотности данных. Он сравнивает плотность точки с плотностью её соседей, выявляя выбросы. Подробнее о LOF.

Алгоритмы поиска ассоциативных правил

Apriori

Apriori — это классический алгоритм, который используется для нахождения частых множеств в данных и извлечения ассоциативных правил. Он помогает выявлять связи между элементами в больших наборах данных.

FP-Growth

FP-Growth (Frequent Pattern Growth) — это алгоритм, который позволяет эффективно находить частые паттерны в данных без необходимости их многократного сканирования. Это делает его более быстрым и эффективным, чем Apriori.

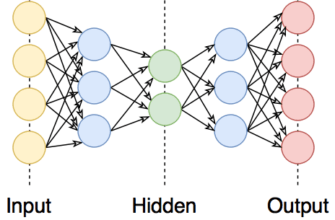

Нейросетевые подходы к обучению без учителя

Самоорганизующиеся карты Кохонена

Самоорганизующиеся карты Кохонена — это вид нейронных сетей, которые обучаются находить структуру в данных без явных меток. Они используются для визуализации и кластеризации многомерных данных.

Автоэнкодеры

Автоэнкодеры — это нейронные сети, которые обучаются кодировать данные в компактное представление и затем декодировать их обратно. Они полезны для снижения размерности и обнаружения аномалий.

Глубокие сети доверия

Глубокие сети доверия — это многослойные нейронные сети, которые обучаются находить сложные структуры в данных. Они используются в задачах кластеризации и генерации данных.

Применение алгоритмов обучения без учителя

- В бизнесе и маркетинге: Анализ клиентских данных и сегментация аудитории.

- В анализе социальных сетей: Выявление сообществ и трендов.

- В биоинформатике и генетике: Обнаружение генетических маркеров и кластеризация данных ДНК.

- В обработке изображений и компьютерном зрении: Снижение размерности и выделение признаков.

- В обработке естественного языка: Анализ текстов и кластеризация документов.

Преимущества и ограничения обучения без учителя

Способность работать с неразмеченными данными

Обучение без учителя позволяет использовать большие объемы неразмеченных данных, что делает его незаменимым в эпоху больших данных.

Обнаружение неочевидных закономерностей

Этот подход позволяет выявлять скрытые и неочевидные закономерности в данных, которые могут быть полезны для принятия решений.

Сложность интерпретации результатов

Одним из главных ограничений является сложность интерпретации результатов, так как алгоритмы находят паттерны, которые могут быть не всегда понятны человеку.

Возможная непредсказуемость результатов

Поскольку алгоритмы работают автономно, результаты могут быть непредсказуемыми, что требует тщательной валидации и проверки.

Оценка качества моделей обучения без учителя

Внутренние метрики оценки кластеризации

Внутренние метрики, такие как индекс Дэвиса-Болдина или силуэтный коэффициент, помогают оценить качество кластеризации, основываясь на структуре самих данных.

Внешние метрики оценки кластеризации

Внешние метрики, такие как точность или F-мера, оценивают качество кластеризации, сравнивая результаты с эталонными данными.

Методы оценки снижения размерности

Для оценки снижения размерности используются такие методы, как объясненная дисперсия или визуальный анализ результатов.

Практические аспекты применения

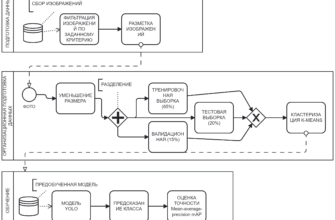

Подготовка данных для обучения без учителя

Подготовка данных включает очистку, нормализацию и отбор признаков, что позволяет алгоритмам работать эффективно и точно.

Выбор подходящего алгоритма

Выбор алгоритма зависит от задачи и данных. Необходимо учитывать характеристики данных и цель анализа.

Настройка гиперпараметров

Настройка гиперпараметров, таких как количество кластеров или размерность снижения, позволяет оптимизировать работу алгоритмов.

Интерпретация результатов

Интерпретация результатов требует анализа и понимания полученных паттернов, что может потребовать дополнительной визуализации и анализа.

Современные тенденции и будущее обучения без учителя

Комбинирование с методами обучения с учителем

Одной из современных тенденций является комбинирование методов обучения без учителя с обучением с учителем, что позволяет использовать преимущества обоих подходов.

Применение в генеративных моделях

Обучение без учителя активно используется в генеративных моделях, таких как GANs, для создания новых данных на основе существующих.

Развитие методов интерпретации результатов

Развитие методов интерпретации результатов обучения без учителя позволяет лучше понимать и использовать полученные данные в практике.

Заключение

Обучение без учителя — это мощный инструмент анализа данных, который позволяет выявлять скрытые закономерности и структуры. Он находит применение в различных областях, от бизнеса до науки, и открывает новые горизонты в понимании сложных наборов данных. С развитием технологий и методов интерпретации, обучение без учителя будет играть все более важную роль в будущем. Не упустите шанс быть в курсе всех новинок в этой захватывающей области! Поделитесь этой статьей в социальных сетях и оставьте свои комментарии ниже.