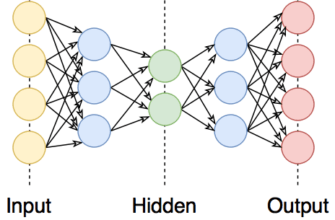

В мире нейронных сетей, где модели становятся все сложнее, регуляризация становится ключевым элементом для поддержания производительности. Регуляризация помогает избежать проблемы переобучения, когда модель запоминает данные вместо того, чтобы учиться их обобщать. В этом контексте Dropout и Batch Normalization (BN) становятся незаменимыми инструментами. Давайте рассмотрим, как эти методы работают и как они помогают улучшить обучение нейронных сетей.

Проблема переобучения в нейронных сетях

Переобучение возникает, когда модель слишком хорошо подстраивается под тренировочные данные, включая их шум и выбросы, и теряет способность к обобщению. Это происходит из-за избыточной сложности модели и недостатка данных. В результате, производительность модели на новых данных ухудшается, что делает ее непригодной для практического применения.

Dropout как метод регуляризации

Основная идея Dropout заключается в случайном «выключении» нейронов во время обучения. Это позволяет модели избегать зависимости от конкретных нейронов и улучшает обобщение.

- Случайное «выключение» нейронов: В каждом обучающем цикле часть нейронов случайно исключается из процесса обучения.

- Вероятность сохранения нейрона: Параметр, определяющий, какая доля нейронов остается активной в процессе обучения.

Существует несколько вариантов реализации Dropout, включая стандартный Dropout и Inverted Dropout. Каждый из них имеет свои особенности и применяется в зависимости от задачи.

Использование Dropout снижает переобучение и повышает устойчивость модели к шуму данных, что делает ее более универсальной.

Batch Normalization (BN)

Batch Normalization помогает стабилизировать обучение, устраняя проблему «внутреннего ковариационного сдвига», которая возникает, когда изменяются распределения входных данных слоев в процессе обучения. BN нормализует входные данные каждого слоя, что ускоряет и стабилизирует обучение.

- Нормализация входных данных слоя: Приведение данных к стандартному нормальному распределению.

- Вычисление среднего и дисперсии: Для каждого батча вычисляются среднее и дисперсия, которые используются для нормализации.

- Масштабирование и сдвиг: После нормализации данные масштабируются и сдвигаются для сохранения выразительности модели.

BN применяется как в сверточных нейронных сетях (CNN), так и в рекуррентных нейронных сетях (RNN), что делает его универсальным инструментом для улучшения обучения.

Сравнение Dropout и Batch Normalization

Оба метода имеют свои особенности и могут быть использованы как отдельно, так и в комбинации. Dropout снижает вероятность переобучения, тогда как BN ускоряет обучение и делает его более стабильным. В сочетании они могут значительно улучшить производительность модели.

Практическое применение

Рекомендации по использованию Dropout

- Выбирайте вероятность сохранения нейронов в зависимости от сложности задачи и структуры сети.

- Применяйте Dropout в скрытых слоях, но избегайте его использования на входном и выходном слоях.

Рекомендации по использованию Batch Normalization

- Размещайте BN слои после каждого нелинейного активационного слоя для максимальной эффективности.

- Настройте параметры BN, такие как масштабирующий и сдвигающий коэффициенты, для достижения оптимальных результатов.

Оптимизация гиперпараметров

Использование Dropout и BN влияет на выбор learning rate. Изменение learning rate в процессе обучения может помочь в достижении лучшего результата. Экспериментируйте с различными стратегиями, чтобы найти оптимальные параметры для вашей модели.

Примеры реализации

Реализовать Dropout и Batch Normalization можно в таких популярных библиотеках, как TensorFlow и PyTorch. Примеры кода для реализации этих методов можно найти в статье на Habr.

Ограничения и проблемы

Хотя BN является мощным инструментом, его использование в RNN может быть затруднено из-за сложности вычисления статистик для последовательных данных. Dropout, в свою очередь, может привести к потере информации, если вероятность сохранения нейронов выбрана неправильно.

Современные тенденции и альтернативные подходы

Регуляризация продолжает развиваться, и новые методы, такие как Layer Normalization и Group Normalization, дополняют или заменяют традиционные подходы, предлагая новые возможности для улучшения обучения.

Заключение

Dropout и Batch Normalization являются мощными инструментами в арсенале машинного обучения. Они помогают избежать переобучения и стабилизировать обучение, что делает их незаменимыми для создания эффективных моделей. Выбирайте подходящий метод в зависимости от вашей задачи и не бойтесь экспериментировать с их комбинациями.

Если вы нашли эту статью полезной, пожалуйста, оставьте комментарий или поделитесь ею в социальных сетях. Ваше мнение важно для нас!